퀄컴 클라우드 AI 100 제출...상용화 임박

알리바바 상용화 가능 부문 첫 제출

전력 측정⋅ECC메모리 등 새 규칙 추가

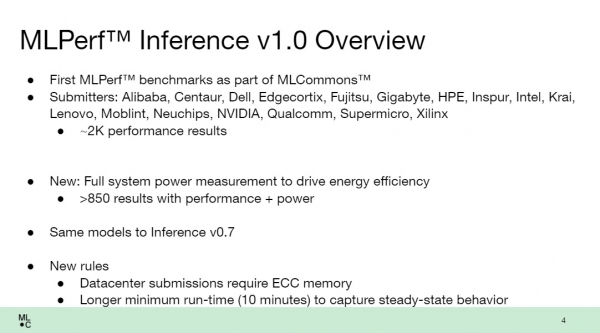

'MLPerf Inference(추론) v1.0' 벤치마크 결과가 발표됐다. 이번 벤치마크에 등재된 업체는 엔비디아⋅알리바바⋅퀄컴⋅인텔⋅자일링스 등 총 15곳이다.

AI(인공지능)가속기로는 엔비디아 A100이 가장 많이 사용됐다. 퀄컴과 알리바바의 성공적 데뷔도 눈에 띄었다. MLPerf 공동 주관사 중 하나인 구글은 이번 추론 벤치마크에 결과를 제출하지 않았다.

이번 1분기 결과의 주목할 점과 새롭게 달라진 점을 짚어봤다.

퀄컴⋅알리바바의 성공적 데뷔

ML Perf v1.0 inference 벤치마크는 ML Perf의 첫 정식 버전 테스트다. 지난 v0.7까지는 베타버전으로 테스트가 진행됐다.

MLPerf는 상용화 여부에 따라 세 가지 범주로 나뉜다. 상용화 가능(Commercially Available), 프리뷰(Preview), 연구개발⋅기타(R&D or Internal) 등이다. (참고 KIPOST 2021년 3월 12일자 <AI 반도체 업체들의 수능시험, 올해는 어떤 스타가 탄생할까>) 제출 부문은 데이터센터⋅엣지⋅모바일과 같은 범주 중에서 여러 부문에 제출 가능하다.

가장 눈에 띄는 것은 상용화 가능 부문에 결과를 제출한 퀄컴이다.

퀄컴은 스마트폰용 AP(애플리케이션프로세서) 시장에서 강세를 보였지만, 데이터 센터용 상용칩을 내놓은 적은 없었다. 지난해 데이터센터 시장을 겨냥한 AI추론 가속기인 'Cloud AI 100' 스펙을 공개했으나 실제 상용칩은 아직 출시되지 않았다. 지난해 퀄컴은 Cloud AI 100이 최대 400TOPS(Tera Operations Per Second) 처리 능력을 갖춘 와트(W)당 성능 기반으로 최첨단 AI추론 효율성을 제공하며 PCIe 타입으로 높은 확장성을 갖췄다고 밝힌 바 있다.

이번 결과는 퀄컴이 스펙상으로만 공개했던 데이터센터용 칩 성능을 제 3자 벤치마크에 의해 공인받았다는 의미가 있다. 동시에 Cloud AI 100 칩 상용화가 임박했음을 암시한다.

퀄컴은 두 개의 AMD EPYC과 다섯개의 Cloud AI 100 카드를 사용해 데이터 센터 카테고리에 결과를 제출했다. TDP(최대 열 설계 전력)가 75W(와트)로 설계돼 150W인 엔비디아 A10과 비교했을 때에는 가성비가 좋다는 평가다. 존 켈리(John Kehrli) 퀄컴 제품 관리 수석 이사는 지난 20일 새벽 진행된 ML Perf 온라인 브리핑에서 "퀄컴의 클라우드 AI 100 가속기가 이번 벤치마크에서 저전력으로 인상적인 추론 벤치 마크 결과를 제공했다"며 “데이터 센터 솔루션은 ResNet모델 오프라인에서 초당 100,077의 추론 결과를 냈다”고 밝혔다.

그러나 퀄컴은 이번 벤치마크에서 다양한 모델에 대한 결과를 모두 제출하지는 않았다. 이미지분류(Image classification)와 사물탐지(Object detection)에만 결과를 제출했다. 엔비디아 등 다른 서버업체들이 다양한 모델에 대한 결과를 제출한 것과는 대비된다. 2개의 모델 이외에 다른 모델들에 대해서도 실제 컴파일(compile)이 잘 되는지 소프트웨어 스택 완숙도에 대한 의문이 제기되는 이유다.

한 팹리스 업체 관계자는 "퀄컴은 전력 대비 성능으로 봤을 때는 인상적인 결과다"며 "일부 모델만 지원하는 것은 상대적으로 쉽다. 다른 많은 모델들에 대해서는 결과를 제출하지 않아 다양한 모델에 대해서 칩이 잘 작동하는지에 대해서는 답을 주지 않았다"고 말했다.

알리바바의 결과 역시 눈길을 끈다.

알리바바는 이번 벤치마크에서 처음으로 상용화 가능 부문에 제품을 제출했다. 데이터센터⋅엣지부문 전체 테스트에 자사 제품을 제출했다.

알리바바는 이전 v0.5벤치마크에 프리뷰 부문에 제품을 제출한 바 있다. 기존 MLPerf의 규칙은 프리뷰에 제품을 제출했다면 6개월 내 상용 가능 제품이 출시돼야 했다. 그러나 알리바바는 프리뷰 제출 이후 6개월 내 상용 제품을 출시하지 않았고, 이후 v0.7에서도 결과를 제출하지 않았다.

주목할 점은 알리바바 칩 성능이 엔비디아 칩 최고 성능과 유사하다는 점이다. 이미지 분류에서 알리바바는 초당 244,992 쿼리를 처리했는데 이는 엔비디아의 초당 최대 쿼리 처리 수인 259,994와 비슷한 수준의 결과다.

국내 스타트업 모빌린트 역시 엣지부문 연구개발⋅기타(R&D or Internal)에 이름을 올렸다. MLPerf v0.7 제출 결과에 비해 레이턴시(응답속도)와 처리량이 개선됐다. 가속기로는 지난번과 동일한 자일링스 '알베오 U250'가 사용됐다. 데이터 유형은 int8을 사용했다.

이번 ML Perf v1.0 inference(추론) 역시 엔비디아 AI가속기가 가장 많이 사용됐다. 암페어 아키텍처 기반의 A100 GPU가 가장 많이 사용됐고, 이번달 출시한 A10과 엔비디아의 이전 세대 추론용 AI 가속기인 T4가 뒤를 이었다.

A100은 엔비디아가 지난해 공개한 데이터 센터를 위한 고성능 AI 프로세서다. TSMC의 7나노 공정으로 제조됐으며, 이전 세대 프로세서 대비 최대 20배까지 성능을 향상시켰다는 것이 엔비디아 측 설명이다. A10은 엔비디아 암페어 아키텍처 GPU, 엔비디아 젯슨 AGX 자비에(Jetson AGX Xavier) 및 젯슨 자비에 NX가 포함된 엔비디아 AI 플랫폼에 이번달 추가된 최신 GPU이다.

엔비디아 측은 "알리바바, 델 테크놀로지스, 후지쯔, 기가바이트, HPE, 인스퍼, 레노버, 슈퍼마이크로가 엔비디아 GPU를 사용하여 총 360개 이상의 결과물을 제출했다"며 "이는 A100이 모든 워크로드에서 가장 높은 성능을 발휘하는 가속기임을 보여준다"고 밝혔다

이번 벤치마크부터 전력측정 추가

이번 벤치마크에서 인상적인 것은 전력 측정이 추가된 것이다.

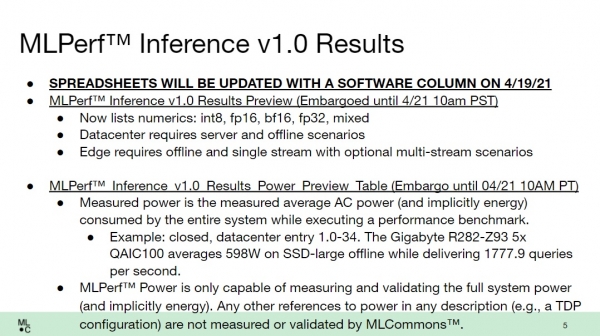

전력 측정은 제출시 선택 사항이며 864개의 결과가 발표됐다. MLPerf 측은 이번 인터페이스를 SPEC(Standard Performance Evaluation Corp)과 협력 개발해 객관성⋅신뢰성을 담보했다고 밝혔다.

방식은 '풀시스템파워(full system power)'를 측정하는 형태다. 하나의 칩이 아닌 서버 전체에 공급되는 파워를 측정하는 것이다. 스토리지, 메모리, 전력 공급 등 모든 부분이 제출된 데이터 측정에 포함된다. 아르만도 아코스타(Armando Acosta) 델 글로벌 HPC 제품 관리 및 기획 이사는 "성능이 높으면 열이 더 많이 발생하는 경우가 많다"며 " 전력 소비는 TCO(총소유비용)를 위한 효율적인 시스템 설계에서 중요한 고려사항"이라고 밝혔다.

또한 모든 D램이 ECC(Error-Code Correction)를 포함해야 하고, 런타임(실행시간)이 최소 10분 이상은 유지돼야 한다는 조건이 추가됐다. ECC 메모리는 오류 검출 기능이 추가된 것으로 '서버용 램'으로 분류된다. 데이터를 저장하는 비트 외에 에러 검출을 위한 추가 비트를 할당하고, 이 비트가 실시간 에러를 수정하는 것이다. 일부 비트에 에러가 발생해도 하드웨어로 실시간 검출과 수정을 통해 문제를 해결할 수 있다.

한 팹리스 업체 관계자는 "메모리에서 데이터 전송 시 한 비트씩 깨지는 경우가 생각보다 빈번하다"며 "특히 데이터센터는 연산량과 발열이 많아 에러 발생 시 치명적이다. ECC메모리를 조건에 넣어 객관성을 높이고자 한 것으로 보인다"고 말했다.

사용되는 데이터 유형의 종류에 대해서도 int8, fp16, bf16, fp32 명시하도록 했다. 데이비드 캔터(David kanter) MLCommons 전무이사(Executive Director)는 "대부분의 경우 기계 학습 알고리즘은 fp32를 사용해 개발된다"며 "8비트 정수처럼 더 작은 데이터를 사용하면 필요한 메모리 양이 줄어들고 결과를 계산하는 데 필요한 전력이 줄어들지만 정확도가 떨어진다"고 밝혔다.

이어 "MLPerf 벤치마크에는 항상 정확도 목표가 있으며, 이는 성능 결과가 실제 고객에게 효용성이 있도록 하는 데 매우 중요하다"며 "이것이 MLPerf가 TOPS라는 단순한 숫자를 넘어 신뢰성을 확보하는 또 다른 방법"이라고 말했다.

데이비드 캔터 MLCommons 전무이사 이메일 회신 전문

1. The reason why the benchmark approved by a third party is important, not the benchmark disclosed by each company.

Benchmarks like MLPerf are critical for creating a shared understanding of performance and progress across a number of different groups, from industry to academia, customers, vendors and competitors within the industry, to folks from different departments or specializations within the same organization.

In the absence of consistent performance metrics or benchmarks, a company is able to use the definitions and tests that best suit their own needs – without a fair comparison to others in the space. A shared understanding of performance helps customers make buying decisions, and helps drive the entire industry forward.

2. AI semiconductors have a very wide spectrum. It is not limited to general purpose, and there are many niche markets. There are also many microminiature low-power edge AI inference semiconductors. Algorithms are also very diverse and change in real time. MLPerf cannot contain all of this. I want to know about your opinion on this.

You are absolutely correct that machine learning is critical for a wide range of markets. MLPerf Inference v1.0 is primarily focused on datacenter and edge applications, but there are many other applications.

We have a TinyML benchmark suite for deeply embedded microcontrollers and also MLPerf Mobile for smartphones, tables, notebooks, and other client devices. Stay tuned for more details!

3. What are the limitations of simply looking at Tops in AI semiconductor performance?

TOP/s or FLOP/s are a theoretical measurement of the computational throughput of a chip. However, in practice customers care about the real performance of a system.

MLPerf™ performance metrics are much more comprehensive and take into account many different system-level factors such as target accuracy, quality-of-service, software, as well as hardware aspects such as compute throughput, memory bandwidth, and other factors.

In the real world, performance is determined by all of these factors, and not just TOP/s. We’ve seen software optimizations alone increase performance by 30% or more within six months on MLPerf benchmarks. Even at the hardware level, many neural networks may not be limited by the computational throughput and may be limited by random memory access, especially in latency critical scenarios. This is why MLPerf was built from the ground up to focus on system performance from the perspective of a customer.

4. AI semiconductor works by organically interlocking software and hardware semiconductors. The software stack is directly related to chip perfection. Nvidia's strength is that it has not only chip performance, but also AI software stack based on CUDA. I'd like to know about your opinion on this part.

MLPerf is a system benchmark, and not just about hardware. A good software stack is critical for success and providing robust performance for a wide range of models. For example, we’ve seen big changes in performance in the MLPerf benchmarks - around 30% over 6 months, through software optimizations alone. MLPerf can measure this performance change due to software and help measure the impact of new software components such as compilers, math libraries, and training frameworks.

5. The new power measurements are introduced from MLPerf Inference v1.0 benchmark. Many companies agree on the importance of power measurement, but are still skeptical about how to ensure the objectivity and reliability of power measurement. I'd like to know about your opinion and MLperf's plan.

The addition of new power measurement techniques, tools, and metrics is consistent with MLCommons’ overall mission to accelerate innovation and create better ML for everyone. Power measurement is essential for bringing transparency to the energy cost of different levels of ML performance, and ultimately creating more energy-efficient algorithms and systems across the industry.

The MLPerf Power approach is built on top of the earlier work by SPEC, which has been used for many years in other server benchmarks. Additionally, we spent over a year thoroughly testing, validating, and verifying our power measurement techniques. One of the big benefits of MLPerf is that many companies across the industry can work together to ensure that we are creating a level playing field that is fair to everyone and accurately measures performance and power.

6.Starting with this benchmark, the type of data used has been specified. Why is this part important for ensuring objectivity?

This describes the numerics system used for performing inference for the submitted system. In most cases, machine learning algorithms are developed using 32-bit floating point, because they have excellent range and precision and typically will have the best accuracy. Using smaller data (e.g., 8-bit integers) will reduce the amount of memory needed and reduce the power for computing a result, but can reduce accuracy. In some scenarios, e.g., identifying a song playing on the radio reducing accuracy is OK, but in other cases, e.g., medical imaging the best accuracy is necessary.

MLPerf benchmarks always have an accuracy target, which is critical to ensure that the performance results are relevant to customers. One of the ways that systems can optimize the overall solution is by enabling smaller data while maintaining acceptable accuracy. This is another way that MLPerf helps go beyond just TOPS. As our results show, not every benchmark can run using the smallest data types - so focusing on TOPS ignores the entire question of accuracy which is critical for customers.

7. What is the most noteworthy point in the results of this latest inference v1.0?

As the Executive Director of MLCommons™, I think that all the submissions are interesting! However, I’m particularly excited about the new power measurements. MLPerf™ Power will help the entire industry design more efficient systems so that we can deliver cutting edge AI capabilities in an environmentally conscious manner. Moreover, in many applications power usage is the ultimate limit on performance!

8. In South Korea, there is a lot of interest in PIM (Processing In Memory) technology that enables computational processing in memory. How do you see the prospects for this technology?

Processing-in-memory is a very interesting approach to ML - but very different compared to traditional CPUs or GPUs. Ultimately, customers are primarily interested in whether the architecture delivers the right performance for their application.

One of the achievements of MLPerf is that our benchmarks represent a wide variety of real-world applications, and can run on a wide variety of systems to create a level playing field for many different architectures. We believe that MLPerf is a great tool for vendors with new technology to demonstrate a robust solution and excellent performance.

9.This is the first time to release v1.0 results, not the beta version. And this year marks the fourth year. I wonder about the meaning and future goals of ML Perf in the AI semiconductor industry.

Our goal is to make better machine learning for everyone. Stepping back, the goal of MLPerf is to help everyone in the industry create better, faster, more efficient systems and help customers pick the right solutions. Machine learning is a very hot area for semiconductors and we are pleased to help the industry evolve in the right direction.